Ở bài viết này thì chúng ta sẽ cùng tìm hiểu về một chí báo có tên khá dài và mois lạ. Chỉ báo Stochastic Gradient Descent. Chỉ báo này sẽ hỗ trợ nhà đầu tư có thể tìm ra các mức biến động và thay đổi của giá ở thị trường đầu tư.

1. Stochastic Gradient Descent là gì?

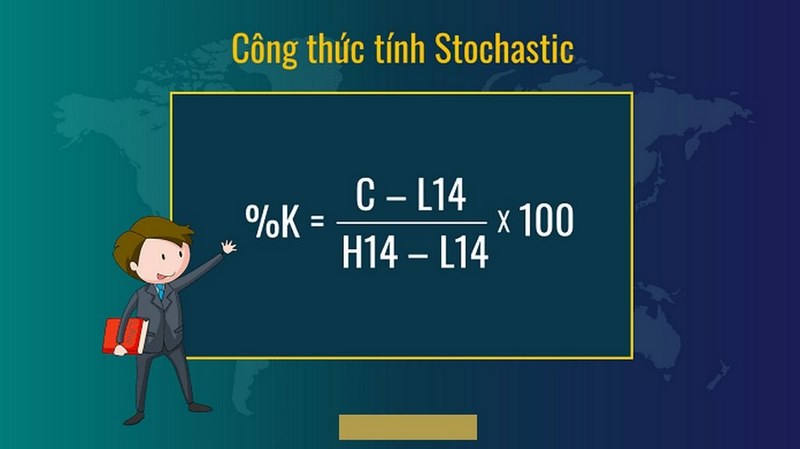

Stochastic Gradient Descent là gì? Ở trong khá nhiều bài nghiên cứu, người ra đã bàn luận khá nhiều về Gradient Descent, đây là chỉ báo cải tiến nhất để có thể được dùng ở việc học một tệp phân chia cho việc Parameterized Learning. Nhưng Vanilla Gradient Descent tiến hành gradient descent có khả năng chậm khi vận hành ở bộ thông tin lớn, ở thực tiễn nó còn có thể được xem là lãng phí tính toán.

Thay vì vậy nhà đầu tư nên ứng dụng Stochastic Gradient Descent (SGD), đây là sự chỉnh sửa đơn giản với thuật toán Gradient Descent đo lường mức độ dốc và cập nhật ma trận tỷ số W dựa vào những bộ thông tin đào tạo nhỏ, thay vì tất cả tập huấn luyện. Trong khi chỉnh sửa này làm cho những bản cập nhật bị nhiễu hơn, nó còn hỗ trợ cho người dùng tiến hành nhiều giai đoạn hơn là học theo gradient (từng bước ở mỗi đợt so với một bước ở từng epoch), sau cùng làm cho hội tụ nhanh hơn và không có tác động tiêu cực đến sự mất mát và phân loại cụ thể.

Stochastic Gradient Descent là tên của một thuật toán quan trọng nhất nếu như đào tạo hệ thống thần kinh sâu. Tuy là hoá thân ngay từ đầu của SGD đã được giới thiệu ở khoảng 57 năm trước, đây vẫn là dụng cụ hỗ trợ hình thành những hệ thống lớn nhằm tìm hiểu những mẫu khác qua những điểm thông tin.

2. Mini-batch SGD là gì?

Cân nhắc thuật toán vanilla GD, rõ ràng là cách thức này sẽ vận hành không nhanh ở những tệp thông tin lớn. Nguyên nhân với sự chậm này là do từng lần lặp lại của Gradient, người dùng cần đo lường cho mỗi thời điểm đào tạo ở thông tin đào tạo của người dùng trước khi họ có được quyền cập nhật ma trận thông số của mỗi người dùng. Với những bộ phận thông tin hình ảnh như ImageNet là đã có khoảng hơn 1,2 triệu hình ảnh đào tạo, việc đo lường này có thể tốn khá nhiều thời gian.

Nó cũng cho thấy rằng kỳ vọng điện toán với toàn bộ điểm đào tạo trước khi tiến hành bước ma trận tỷ số của người dùng là lãng phí đo lường và không hỗ trợ được gì với mô hình người dùng.

Thay vì vậy thi những gì mà người dùng nên làm là nhiều bản cập nhật của người dùng. Có thể cập nhật mà giả nhằm quy đổi Vanilla GD nhằm trở thành Stochastic Gradient Descent qua việc thêm lệnh gọi hàm:

Yếu tố khác biệt chủ yếu giữa gốc Vanilla GB và Stochastic Gradient Descent là sự bổ sung vào hàm next training batch. Thay vì đo lường mức độ dốc của người dùng ở toàn bộ tệp thông tin, người dùng thay vì vậy sử dụng mẫu thông tin người dùng nhận được một batch. Người ta đánh giá gradient ở batch và cập nhật trọng số người dùng ma trận W qua góc độ thực thi, người dùng có thể nỗ lực chọn bất kỳ những mẫu đào tạo của người dùng trước khi được dùng SGD do thuật toán nhạy cảm với batch.

3. Vì vậy, tại sao phải sử dụng kích thước batch> 1?

Để có thể bắt đầu, kích thước của batch cần lớn hơn 1 hỗ trợ giảm đi phương sai ở cập nhật tham số, làm do hội tụ ổn định hơn.

Tiếp theo thì mũ hai hay được dùng với kích thích batch vì chúng hỗ trợ cho những thư viện tối ưu được đại số tuyến tính nhằm tối ưu được hiệu quả.

Nhìn chung thì kích thước lô nhỏ sẽ không phải là siêu tham số, đừng nên quá quan ngại về chúng. Nếu dùng GPU nhằm huấn luyện mạng thần kinh, cần phải xác định có bao nhiêu ví dụ đào tạo sẽ thích hợp với GPU người dùng và tiếp theo dùng sức mạnh gần nhất với cả hai kích thước batch miễn là batch sẽ thích hợp cùng với GPU.